AIの話になるとMidjourneyやStable Diffusion、DALL·Eなどのプロントを行い画像を生成する物が流行っていますね。

そんなtwitterのTLで大変興味深いツイートがありました。

動画をみれば分かるようにテキストボックス内に命令・プロンプトを行うことで、動画が編集されるとのこと。

後半は、既存の他AI画像生成に似ているところはありますが、

前半部分の動画を読み込む、シネマティックなフィルタをかける、オブジェクトを消去するなどの操作をテキストから自動化するのはとても新鮮に感じます。

AfterEffectsやNukeなどの本格的なツールを使う人からすると、精度の高さやエフェクトのコントロールを考え、使えるのか不安な部分がありますが、今後の動画編集や加工、VFXまで変えていきそうな操作方法のように感じました。

例えば、「①手前の人のマスク作って」と命令し、「②背景を生成して」、「①と②を合成して」、「①を②に馴染ませて」などなど、AIには詳しくはないですが、上の動画を見ていくと、今後やっていけそうな気がします。。。

また、それらがある程度の強度やコントロールが効くように今後なっていくとしたら、Nukeなどでノード単位で導入が可能になりそうで楽しみです。(実際にCopyCatなどはありますが、機械学習をさせなければならない部分があるので個人での導入に時間がかる。。)

ここまで妄想をしてきましたが、そうさせるほどにAIの発達による、プロンプトでのかなりソフトなプログラミングのようなテキスト入力が成立しつつあるように感じました。

Runway機能紹介

今回Twitterの動画きっかけで調べましたが、意外に多機能で使いこなしたとしたらこれ一つでも映像制作などの仕事が行えそう。。

- オンライン編集

- リアルタイムコラボレーション

- Magic tools

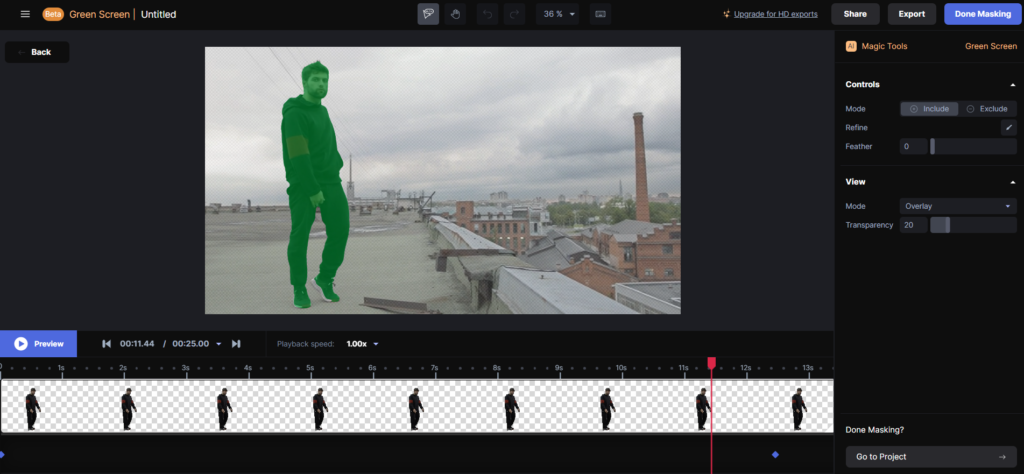

Green Screen Mask

AIを用いた自動マスキング

Inpainting

こちらもAIを用いた塗りつぶし。

オブジェクトの消去などが行える - Automatic Beat Detection(自動ビート検出)

ワンクリックでクリップを音楽のビートに合わせます。 - 自動字幕

- Automatic Noise Removal(自動ノイズ除去)

- 豊富なテンプレート

少し試してみました

頭、体、足元 三ヶ所ほどクリックして人物をマスク処理かけた結果。。。

クリップ通しては思ったよりも追いかけてマスクづくりができた印象です!

処理にかかった時間は10秒~20秒程度。(思ったより早い印象です。)

もちろんクオリティ的には、やや硬めで、モーションブラーは怪しいです。

ただ、3クリックでなので、、、

またオンラインエディターなので使っているPCの処理は、インターネット通信と動画表示くらいです。

この記事を書きながらでも、メモリが8GB程度の使用量でした。

未来を感じるオンラインビデオエディター一度触ってみてはいかがでしょうか。

Runway – Online Video Editor

「Text to Video」の早期アクセスもこちらから行えます。